2019年ですね!!

明けましておめでとうございます。今年もよろしくお願いいたします。

さてさて、一年の計は元旦にあり!!というわけで、毎年やっている今年の目標を立てるをやります。

まずは…去年の目標がどうだったかなんですが…

明けましておめでとうございます。

①売上 〇円

えっとですね、うちの決算は3月なので、1月に目標が達成できたかどうかって話は、結局去年度のことを話しているわけなのですが、去年度は目標を達成できました!!(o^―^o)ニコ

本当に、お客様、パートナーの皆様、何よりスタッフのみんなのおかげです!!

ありがとうございます。

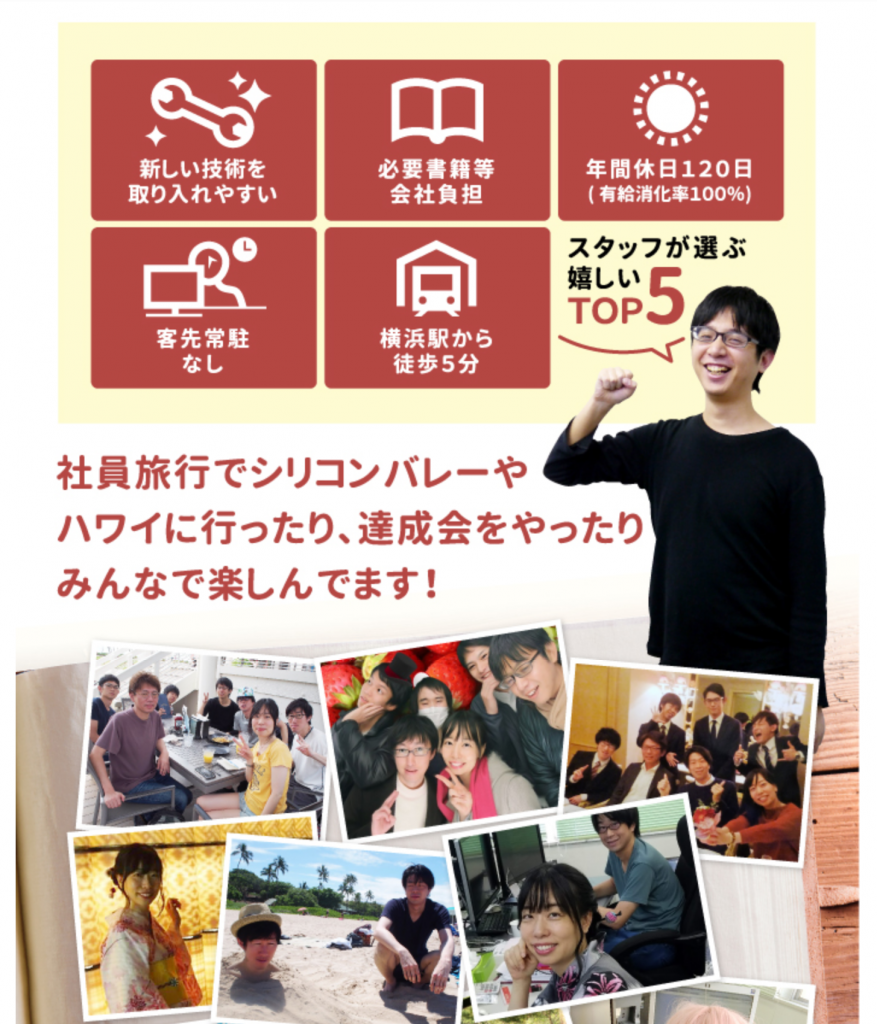

2018年は、社員旅行でハワイにも行けましたし、いろんな意味で恵まれていました。

社員旅行でハワイに行ってきました(前編)

プライベートでも大変楽しく、充実した一年でした(o^―^o)

②本を毎月読む

これはねー

大体できたんじゃないかと思うのですが… 記録がないっ!!

このブログに記録を残しているのが

ぐらいなんですよねー。

いや、ここに書いてないのも読んでるんですが。

記録にしないと測定できないよね(´・ω・`)

③ジムに、月に4回以上行く!

行けてません。

…。

終わり。

んじゃ去年の目標終わり!今年の目標です!

①売上 〇円

後3か月しかないのですが、ちょっと無理ゲーっぽい…。

俺の小宇宙よ!奇跡を起こせ!!!☆彡

…で売り上げが上がればいいのですが。

できることをしていくしかないですね。人事を尽くして天命を待つ!!

②本を毎月読む & 記録を取る

去年と同じなんですが、これは続けてやったほうがいいなーと。

休日に、コーヒーとか飲みながら、本を読んでる時間ってなんか幸せなんですよね。(๑`·ᴗ·´๑)

人間に生まれてよかったなーと思える瞬間です。

自分も楽しいし、ためになるし、でいいことずくめです。

ただ、記録取ったほうがいいなーと。

大体、本は読んだら売っちゃうので、記録取っとけば、本の内容を後で思い出せるし、勉強している自己満足が2倍になる点でおいしい!!

③ジムに1か月に4回行く & 記録を取る

毎年言っててダメじゃん。

…

なんですが!!

ですが!!!!!!

本当に大事だと思ってるんですよ…。(´・ω・`)

ナポレオンさんも、目標を立てることが大事って言ってたし…(目標を立てると、実際と目標がどれだけ乖離しているかがつかめるかららしい)

昨日の大晦日、格闘技を見てて、メイウェザー VS 那須川天心 の一戦を見てました。

あれ、後で調べたら41歳と20歳の戦いだったんですね。

えっっっ!!!

私と同じ年じゃん!!(꒪ȏ꒪)

なんか、むしろ20代なのかと思ってた…。国歌が流れてるときとかにオラオラしながらウロウロしてる感じとか…

内容としてはメイウェザーさんの圧勝だったんですが。

1ラウンドTKOで、勇二郎の試合ぐらいの感ありましたね。

同じ年齢の男性で、ボクシングという激しすぎるスポーツができるのがまずすごい。

それに加えて、フットワークももちろん軽いし、体も軽いし、パンチもものすごく速いし。

私の友人で佐々木基樹さんという最近引退したボクサーもいらっしゃいますが。

本当に毎日の努力がすごいと思う。

年齢というのは仕方ないにしても、肉体というのはしかるべきメンテナンスをすれば、全然結果が違うんだなーって強く思いました。

周りを見ても、運動している人は、なんか劣化が遅いんですよ。

劣化っていうと、なんかレベル低く感じるかもしれませんが、人生で達成したい目標がある。

それに、絶対に必要なのが、心と体の健康だと思ってます。

健康ゲージが低くなると、結局後で課金することになるので、なるべく大事にしていきたいです。

④ブログをもっと書く!

これ、うちのスタッフさんに言われたんですよね。

「もっと、ちゃんと情報発信していったほうがいいです。会社の発展とか、人集めるとかのために。」

って。

うん。実は、私も心の中ではそう思ってる。。。

だが…

だが…

いや、やります。ヾ(`・ω・´)ノ

1か月に8回、つまり1週間に2回は書く!(`・ω・´)

8回の根拠ですが、さっき今の投稿ペースを調べたんですよ。8月 6回

9月 2回

10月 6回

11月 7回

12月 5回これで、足りないようなので、まぁ現実的なところで8回かな… と…しかし、何を書いたらええんやろ というのはいつも考えどころなんですよね。

あんまりいつも会社の宣伝でも、読む人いなくなっちゃうんでダメかなというのは自覚してますwww

なので時々私の日常とかなんかも書いたりしてます。

⑤お客様のところに、6回は行く!

2か月に1度ぐらいはお客様のところを訪問したいです。

大きい会社さんでも、小さい会社さんでも、ですね。

ついつい、私は会社でプログラミング業務をすることが忙しすぎで、会社にこもっちゃうんですよね。

でも、会うって大事。会わないとわからないことが多いので。

事件は現場で起きてるんだーっ!!

というわけで、目標終わり!

(*´Д`)ハァハァ 長かった…。

正月飾りをつけた実家のシェルティのサスケです。

めっきり弱っちゃって…。悲しい…。( ˃ ˄ ˂̥̥ )

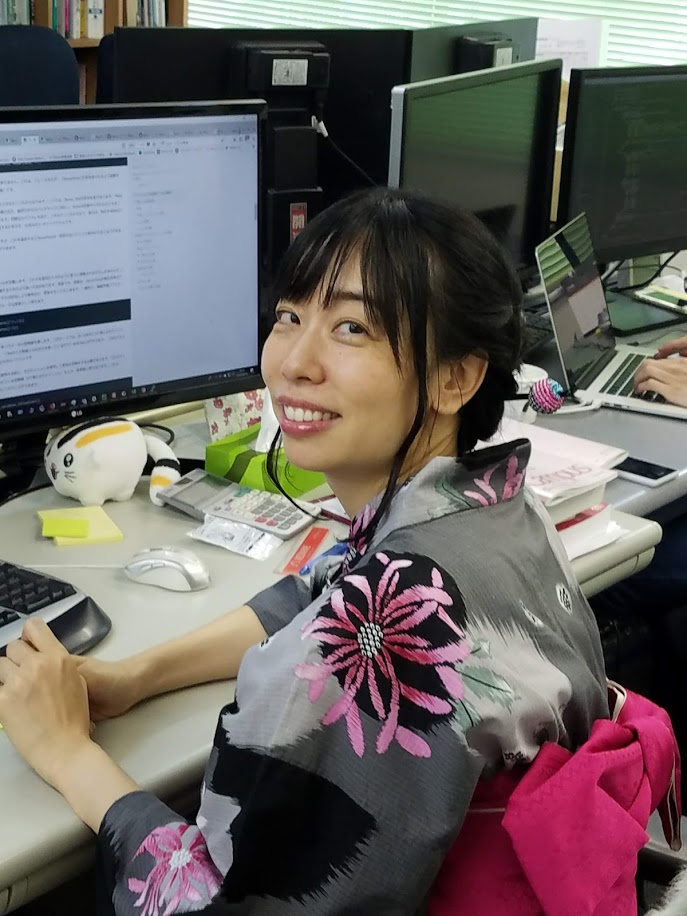

今年は、今日晴れ着着なかったんです。違う日に着るつもりなので( ⸝⸝•ᴗ•⸝⸝ )

なので、ちょっと前に着た着物の写真でも貼っておきます。

これ、大島なんですよ。なんと、帯も合わせて友達からいただきまして!!!

本当にありがとうございます。

ちな、

「極妻みたい」

って言われましたwww

ちな、極妻2が結構好きです。

さて、今年の弊社の年賀状はこれ!

Nがいい感じにかわいいのを作ってくれました(*ˊᵕˋ*)

https://mailchi.mp/89a16e59ce52/v8d3s4mjor-3295001

今年も、社員一同、がんばっていきます!

何卒よろしくお願い申し上げます。