今日が今年度最後の営業日ですね!!!(`・ω・´)

えー、1か月ブログ書いておりませんでした…。

手からギャリック砲が出るほど忙しくって…(>_<)

年度末で仕事が忙しいのに加え、自宅の引っ越しとか、旅行×2とかでしたね!!!

しかし、このニュースだけは!!!!口を出したかった~

https://headlines.yahoo.co.jp/hl?a=20190322-00000024-zdn_n-sci

ゼンリンとの提携を解消したGoogle、提携し始めたMapbox【週刊宇宙ビジネスニュース 3/18~3/24】

ゼンリンとGoogle決裂…っ!!

これは業界に激震ですね~(`・ω・´)

しかも!!!なんとゼンリンの提携先はMapbox!!!!!

おおー。

MapboxがまだまだOSMに毛の生えた感じだったころから使い続け、じゃっかん普及活動みたいなことをしてきた私としては、日経新聞とかYahooニュースにMapboxの名前が載るだけでも感無量です。(つД`)

私の普及活動の2例を…

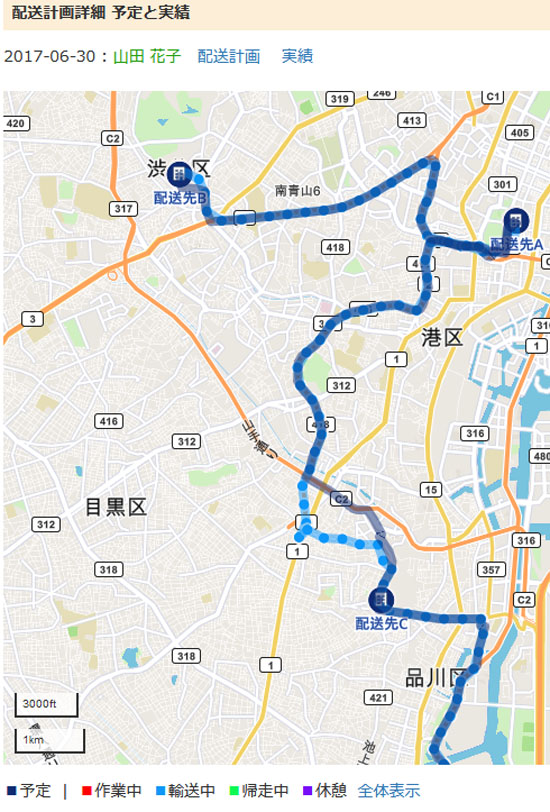

建設会社さんでの、建設資材の運搬などでのSmart動態管理の利用が増えています

IoT縛りの勉強会でLTをしてきました

しかし…。

喜んでもいられない…。

逆に、Mapboxが高くなってしまうかもしれない。((((;゚Д゚)))ガクガクブルブル

Mapboxに問い合わせたところ、今のところ値上げなどはないらしいですが。

というか、このニュースは裏を返せば、Googleさんが、

「もうゼンリンの手を借りなくても、自分たちで地図作れるわ!!!ウワハハハ」

ということだと思うのですよ。

ゼンリンさんって、昔聞いた時は、調査員という方が全国にいっぱいいらっしゃって、その方たちが歩いて地図を作っているそうなんですよね。

なので、細かい路地を入ったところが林さんのお宅だ、などという情報がわかるんですね。

簡単に端的に言いますと、人海戦術みたいなところがあります。

Googleさんは、スマホの位置情報などを使ってるんでしょうか。

そして、Mapboxは、元々Open Street Mapという、地図をみんなで作っていこう、というプロジェクトのデータを今までは使っています。

地図のWikipedia版みたいなもんですね。

私は、個人的にはこの陣営に乗りたかった。

例えば、災害が起こった時… 地震などで道路が通行止めになる、などの情報を、この方法ならいち早く共有できるからです。

そして、それってすっごい大切なことなんですよね~(`・ω・´)

なので、これからは人海戦術よりもオープンソースの地図だろ~ と思ってたわけです。

また、心情的に常にジャイアントキリングに挑む会社や人を応援したいですね。

だからって採用しているわけではないですが…。

しかし、人海戦術とオープンソースがどう合体するのか…。

そして、Googleの地図の精度がどうなるか…

また、今までGoogle mapはオフラインだと使えない、法人利用が高額、印刷できないなどの縛りがあり、これが全部ゼンリン由来だと言われていましたから、この弱点が克服できたらGoogle Mapの方が強いのかもしれません。

弊社の仕事に密接にかかわる点なので、興味深くウォッチしていきたいですし、なんか情報などあれば、ぜひ教えてください。m(_ _)m